Archives de catégorie : Ansible

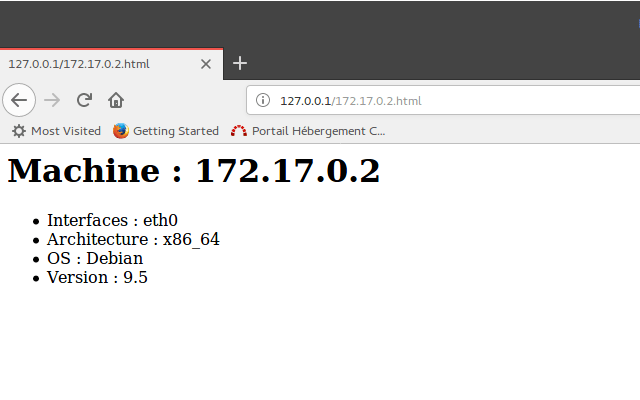

[Ansible] – comment utiliser les gather_facts et tenir à jour un début de cmdb ?

Ansible – installer un applicatif (ex. WordPress)

Ansible – Comment créer un user et une base mysql ?

Ansible – installer un serveur LAMP automatiquement

Ansible – les différents niveaux de variables

Ansible est un orchestrateur simple d’utilisation dès lors que l’on en retient les concepts de base. Parmi ces concepts, la hiérarchie des variables fait partie des essentiels. Je vous propose d’y revenir en vidéo. [youtube https://www.youtube.com/watch?v=_8Az2egUKwY&w=700&h=500] D’ailleurs n’hésitez pas à…

Ansible – prise en main de checksum, set_facts, register et block

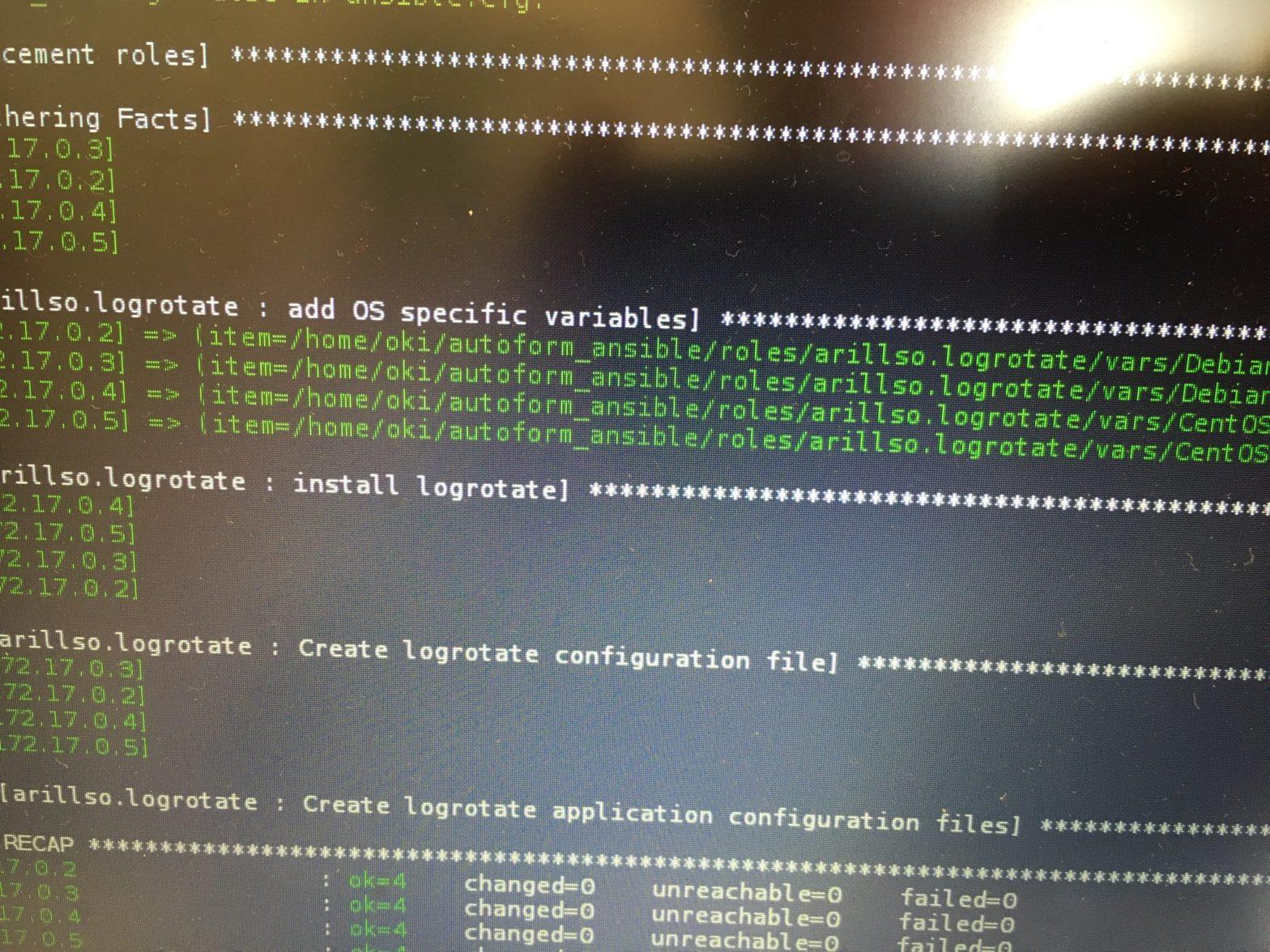

[Ansible] : comment installer et configurer logrotate ? et trouver un rôle adapté

[Ansible] : lister les variables de rôles non documentées dans le README.md

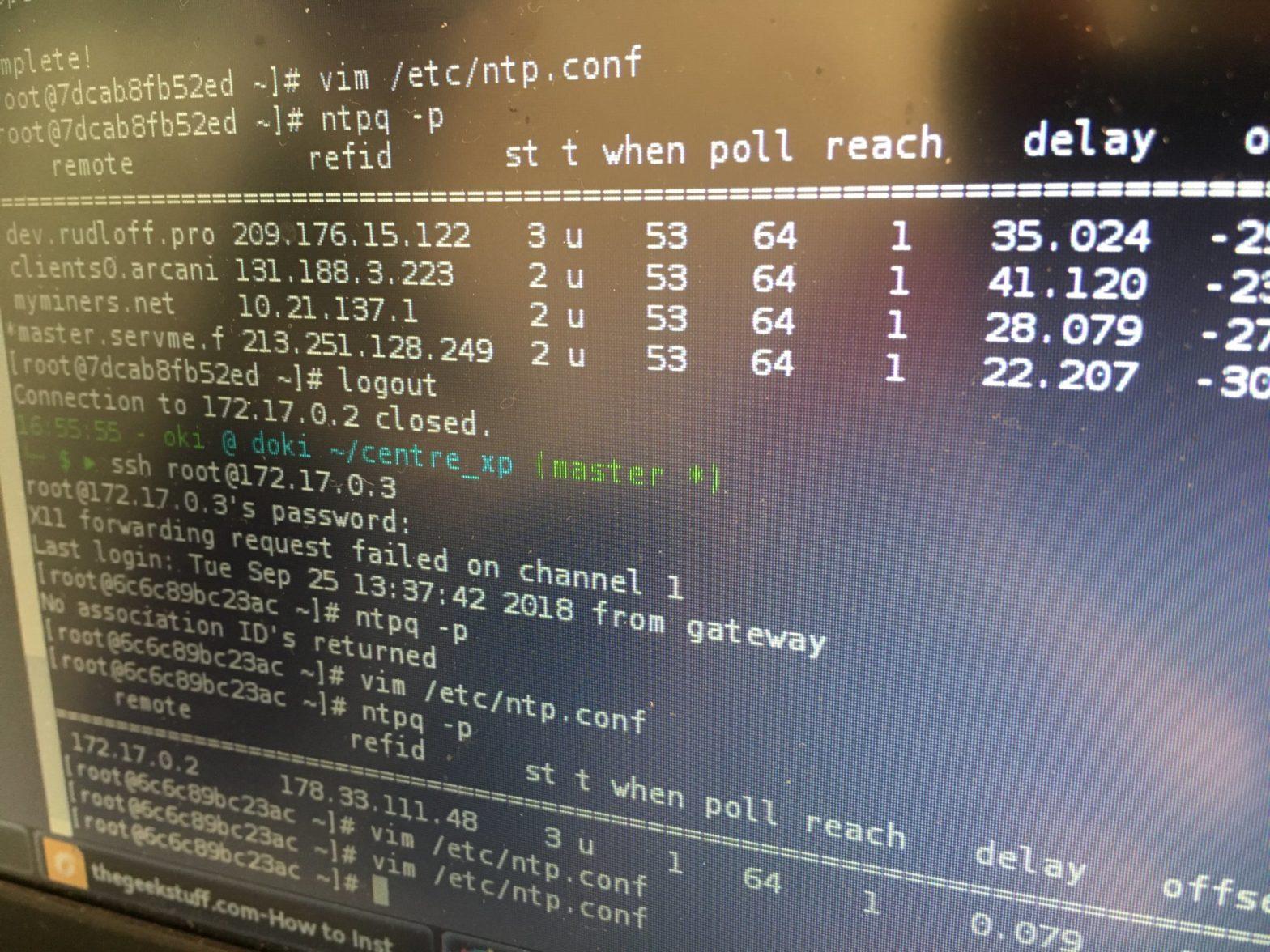

[Ansible] : comment installer un client et un serveur ntp ?

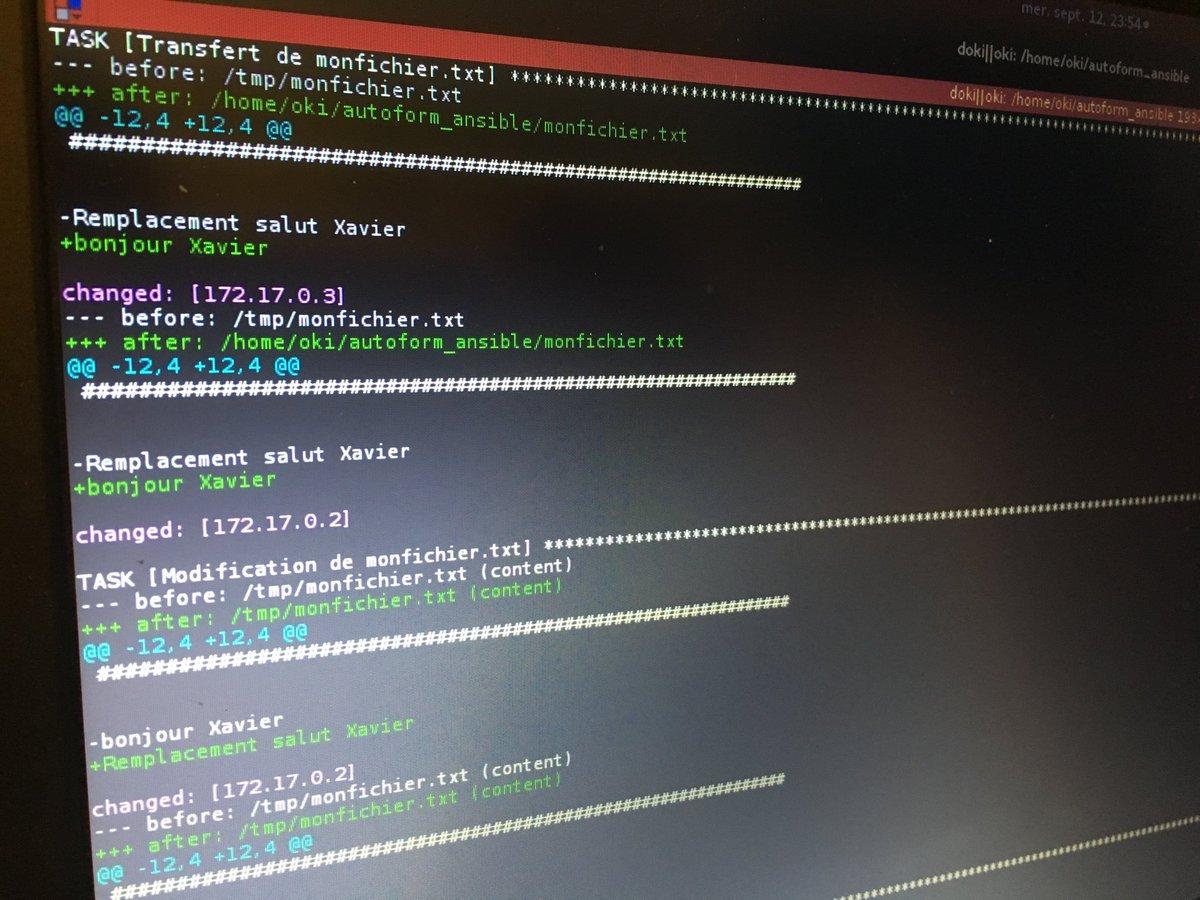

[Ansible] : commençons simplement : copie de fichiers, modification/écriture avec copy et lineinfile