Archives de catégorie : Docker

Un script bash et docker pour vous aider à développer des rôles ansible

Docker – changer les ip par défaut

[Docker] : Comment prendre en compte un proxy pour puller/pusher et comment le passer dans un conteneur ?

[Docker] : mettre à jour toutes les images en une seule ligne de commande

[docker] : copier un fichier de votre host vers un container avec tar

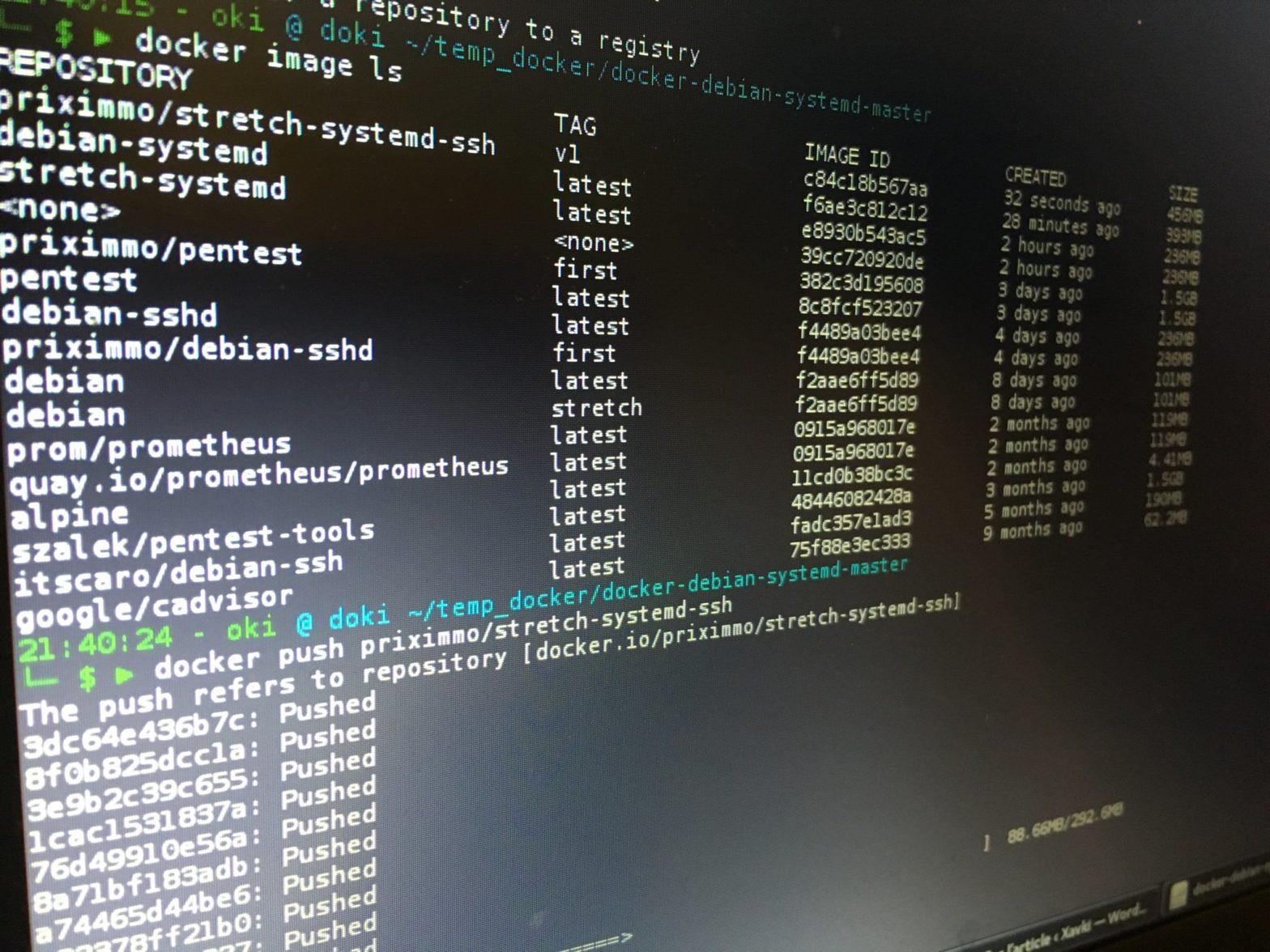

[Docker] : comment créer une image à partir d’un conteneur et la pousser ?

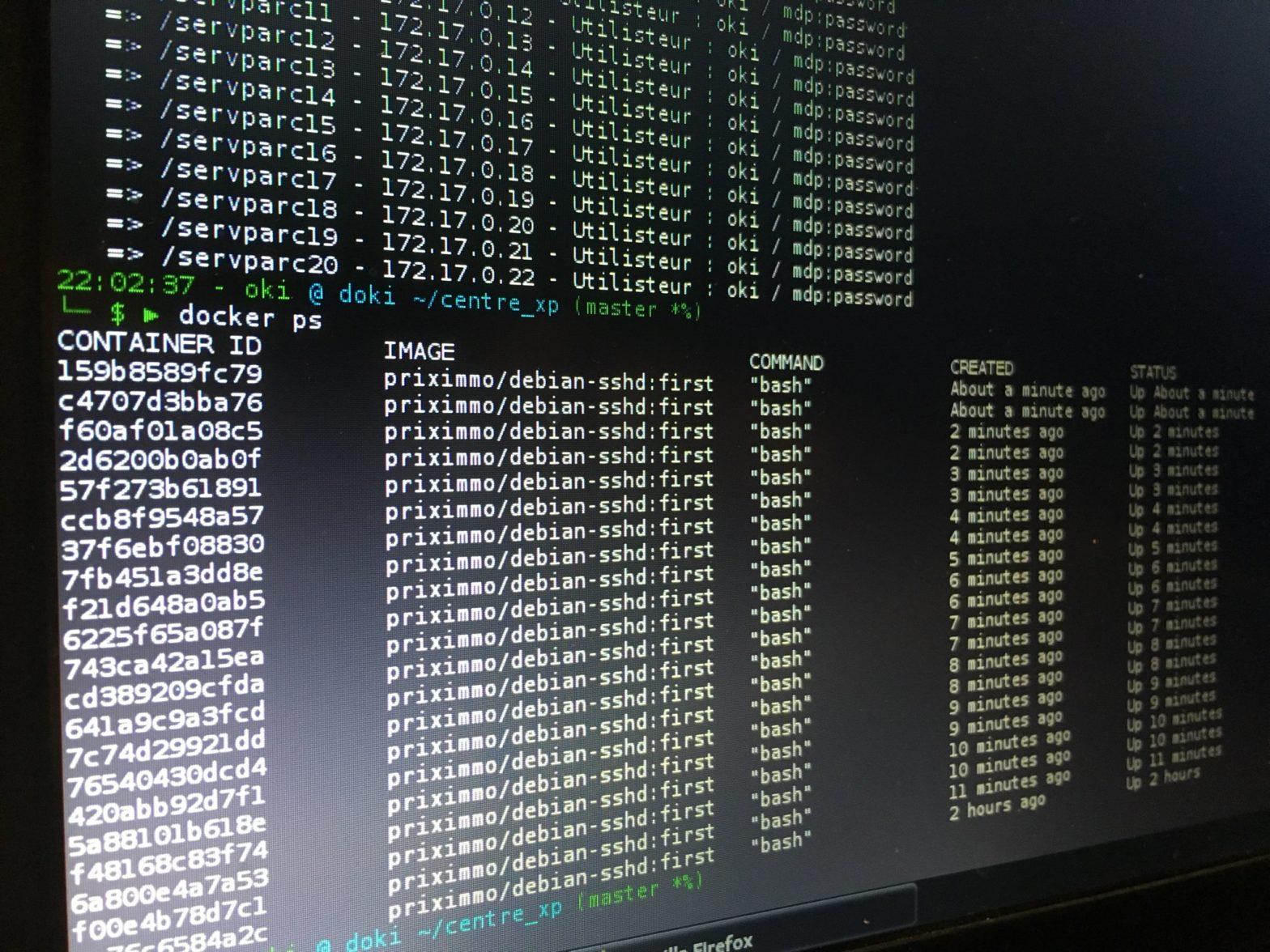

[Docker][Ansible] : comment se créer un mini datacenter de test sans VM ? (parc de conteneurs)